Desperado

Конфуций

Вы делились болью с ИИ, а он поделился ею с государством — и это не метафора.

Генеральный директор Meta* Марк Цукерберг активно продвигает идею будущего, в котором искусственный интеллект станет не просто помощником, но чем-то вроде личного советника, хорошо знающего человека. В его представлении у каждого будет ИИ, способный заменить психолога — особенно для тех, у кого нет возможности обратиться к живому специалисту. С технической точки зрения идея уже воплощается: миллионы пользователей по всему миру откровенничают с чат-ботами. Кто-то использует специализированные терапевтические приложения, но многие предпочитают общаться с универсальными платформами, такими как ChatGPT от OpenAI, Meta AI или Grok от xAI.

Однако это новое поведение становится потенциально опасным — не столько из-за того, что говорит сам бот, сколько из-за того, кто может получить к этим разговорам доступ. Под маской заботы разворачивается тревожная тенденция: технологические корпорации призывают пользователей делиться своими самыми сокровенными мыслями и переживаниями, а государственные структуры — собирать максимально возможный массив личной информации, зачастую пренебрегая правовыми рамками и этическими нормами.

Федеральные власти США уже демонстрируют готовность использовать частные данные для давления и преследования. Иммигранты лишаются виз за законные высказывания, студенты попадают под арест за статьи в газетах, а правительство активно вмешивается в академические программы и медиа, обвиняя их в «недопустимой» политике инклюзии. Министр здравоохранения Роберт Кеннеди-младший предлагает заменить антидепрессанты трудовыми лагерями, а ведомство, которое он возглавляет, намерено создать федеральную базу данных людей с аутизмом — с использованием медицинских файлов и носимых устройств.

На фоне этого департамент под названием DOGE — возглавляемый Илоном Маском — пытается централизовать сбор данных обо всех американцах, включая информацию из разных госструктур. Его первые действия включали раскрытие информации о малозаметных госслужащих, сопровождавшееся целенаправленными онлайн-атаками.

Тем временем крупные ИИ-платформы становятся основными каналами для исповеди миллионов пользователей. И это платформы, чьи владельцы явно стараются сблизиться с Дональдом Трампом. Маск работает на правительство, Цукерберг активно лоббирует интересы Meta, а Сэм Альтман из OpenAI поддерживает приоритеты администрации Трампа, включая снятие ограничений с энергетики и отказ от регулирования ИИ на уровне штатов. Даже Google, стоящая за Gemini AI, действует осторожно в том же направлении.

Пока пользователи делятся своими страхами, мыслями о самоубийстве, гендерной идентичности или расовой несправедливости, власти получают всё больше рычагов для вмешательства. Особо уязвимыми становятся те, кто уже попал в фокус — медицинские работники, активисты, сотрудники университетов и представители НКО. Даже единичная фраза, случайно сказанная в чате, может привести к визиту иммиграционной службы или к проверке «нелегальной политики DEI» в организации.

Чат-боты, по сути, расширяют уязвимости традиционного интернета. Переписка с ботом зачастую более интимна и эмоциональна, чем поисковые запросы. При этом она не защищена сквозным шифрованием, как, например, чаты в мессенджерах. И хотя компании обещают защищать данные, нет гарантии, что они не передадут их по первому требованию — особенно в условиях давления или манипуляций.

Опыт предыдущих лет, включая программы слежки АНБ и вскрытые Эдвардом Сноуденом системы массового наблюдения, показал, насколько легко и незаметно государство может получить доступ к самым личным данным. Теперь же вместо звонков — разговоры с ИИ, и следить за ними становится ещё проще.

На фоне этого возможны любые последствия: от утечки личных разговоров до прямого вмешательства в частную жизнь. И всё это может быть подано под предлогом защиты детей, борьбы с терроризмом или медицинской помощи.

Компании могли бы повысить стандарт конфиденциальности, особенно в ИИ-приложениях, имитирующих терапию. Например, внедрить принципы HIPAA или реализовать технологические решения, исключающие доступ к логам. Но вместо этого те же самые корпорации поддерживают политиков, заинтересованных в подавлении свободы высказываний и контроле над личной жизнью граждан.

Представители Meta* и OpenAI не стали детализировать меры защиты личных данных. Вместо этого они подчеркнули, что их ИИ не заменяют врачей и при необходимости рекомендуют обратиться к профессионалам. xAI и Google отказались от комментариев. Хотя доказательств массового мониторинга логов ИИ пока нет, реальность стремительно приближается к антиутопии. Всё больше новостей звучат так, как ещё вчера казались бы конспирологией. А учитывая, насколько личными стали разговоры с ИИ, именно они могут стать новой точкой входа для тотального контроля.

Фото: Facebook / Gemini.AI | В Google изменили свою политику касательно ИИ

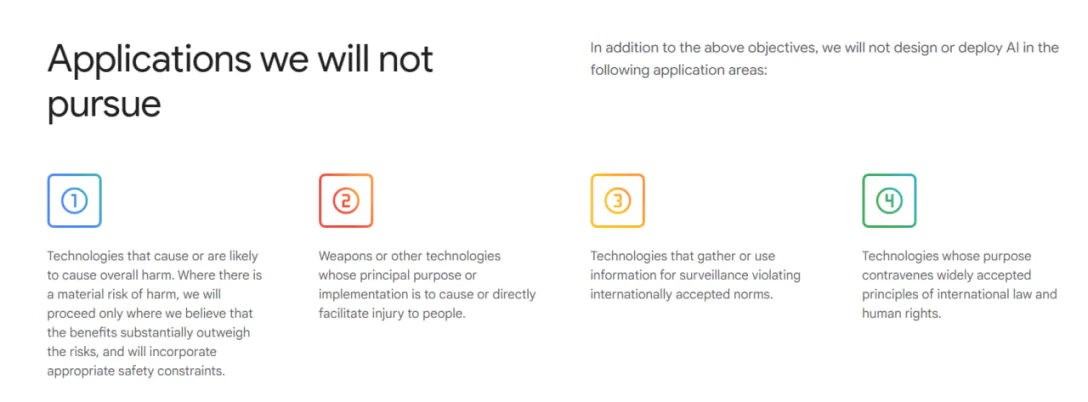

Принципы Google больше не содержат пунктов, исключающих применение ИИ для создания оружия, слежки и других технологий для причинения вреда людям.

Во вторник, 4 февраля, компания Google обновила свои этические принципы в отношении искусственного интеллекта (ИИ), отказавшись от обязательства не применять данную технологию в качестве оружия или средства наблюдения. Об этом пишет The Washington Post.

Ранее принципы Google в отношении ИИ включали раздел, где перечислялись области, в которых компания не будет разрабатывать или внедрять ИИ. Согласно

Принципы Google касательно ИИ от 30 января 2025 года

Фото: Скриншот

По состоянию на 5 февраля на

В

"Мы считаем, что демократии должны лидировать в разработке ИИ, руководствуясь такими основными ценностями, как свобода, равенство и уважение прав человека. И мы считаем, что компании, правительства и организации, разделяющие эти ценности, должны работать вместе, чтобы создать ИИ, который защищает людей, способствует глобальному росту и поддерживает национальную безопасность", — заявили Хассабис и Маньика.

В обновленной версии принципов Google по ИИ говорится, что компания будет использовать человеческий надзор и принимать обратную связь, чтобы гарантировать, что ее технология используется в соответствии с "общепринятыми принципами международного права и прав человека". Кроме того, компания обещает тестировать свою технологию, чтобы "смягчить непреднамеренные или вредные последствия".

Напомним, инженер, известный в сети под псевдонимом

Ранее, глава Стратегического командования США генерал Энтони Коттон заявил, что система ядерного командования, управления и связи нуждается в модернизации для повышения устойчивости к новым угрозам, в частности за счет

Генеральный директор Meta* Марк Цукерберг активно продвигает идею будущего, в котором искусственный интеллект станет не просто помощником, но чем-то вроде личного советника, хорошо знающего человека. В его представлении у каждого будет ИИ, способный заменить психолога — особенно для тех, у кого нет возможности обратиться к живому специалисту. С технической точки зрения идея уже воплощается: миллионы пользователей по всему миру откровенничают с чат-ботами. Кто-то использует специализированные терапевтические приложения, но многие предпочитают общаться с универсальными платформами, такими как ChatGPT от OpenAI, Meta AI или Grok от xAI.

Однако это новое поведение становится потенциально опасным — не столько из-за того, что говорит сам бот, сколько из-за того, кто может получить к этим разговорам доступ. Под маской заботы разворачивается тревожная тенденция: технологические корпорации призывают пользователей делиться своими самыми сокровенными мыслями и переживаниями, а государственные структуры — собирать максимально возможный массив личной информации, зачастую пренебрегая правовыми рамками и этическими нормами.

Федеральные власти США уже демонстрируют готовность использовать частные данные для давления и преследования. Иммигранты лишаются виз за законные высказывания, студенты попадают под арест за статьи в газетах, а правительство активно вмешивается в академические программы и медиа, обвиняя их в «недопустимой» политике инклюзии. Министр здравоохранения Роберт Кеннеди-младший предлагает заменить антидепрессанты трудовыми лагерями, а ведомство, которое он возглавляет, намерено создать федеральную базу данных людей с аутизмом — с использованием медицинских файлов и носимых устройств.

На фоне этого департамент под названием DOGE — возглавляемый Илоном Маском — пытается централизовать сбор данных обо всех американцах, включая информацию из разных госструктур. Его первые действия включали раскрытие информации о малозаметных госслужащих, сопровождавшееся целенаправленными онлайн-атаками.

Тем временем крупные ИИ-платформы становятся основными каналами для исповеди миллионов пользователей. И это платформы, чьи владельцы явно стараются сблизиться с Дональдом Трампом. Маск работает на правительство, Цукерберг активно лоббирует интересы Meta, а Сэм Альтман из OpenAI поддерживает приоритеты администрации Трампа, включая снятие ограничений с энергетики и отказ от регулирования ИИ на уровне штатов. Даже Google, стоящая за Gemini AI, действует осторожно в том же направлении.

Пока пользователи делятся своими страхами, мыслями о самоубийстве, гендерной идентичности или расовой несправедливости, власти получают всё больше рычагов для вмешательства. Особо уязвимыми становятся те, кто уже попал в фокус — медицинские работники, активисты, сотрудники университетов и представители НКО. Даже единичная фраза, случайно сказанная в чате, может привести к визиту иммиграционной службы или к проверке «нелегальной политики DEI» в организации.

Чат-боты, по сути, расширяют уязвимости традиционного интернета. Переписка с ботом зачастую более интимна и эмоциональна, чем поисковые запросы. При этом она не защищена сквозным шифрованием, как, например, чаты в мессенджерах. И хотя компании обещают защищать данные, нет гарантии, что они не передадут их по первому требованию — особенно в условиях давления или манипуляций.

Опыт предыдущих лет, включая программы слежки АНБ и вскрытые Эдвардом Сноуденом системы массового наблюдения, показал, насколько легко и незаметно государство может получить доступ к самым личным данным. Теперь же вместо звонков — разговоры с ИИ, и следить за ними становится ещё проще.

На фоне этого возможны любые последствия: от утечки личных разговоров до прямого вмешательства в частную жизнь. И всё это может быть подано под предлогом защиты детей, борьбы с терроризмом или медицинской помощи.

Компании могли бы повысить стандарт конфиденциальности, особенно в ИИ-приложениях, имитирующих терапию. Например, внедрить принципы HIPAA или реализовать технологические решения, исключающие доступ к логам. Но вместо этого те же самые корпорации поддерживают политиков, заинтересованных в подавлении свободы высказываний и контроле над личной жизнью граждан.

Представители Meta* и OpenAI не стали детализировать меры защиты личных данных. Вместо этого они подчеркнули, что их ИИ не заменяют врачей и при необходимости рекомендуют обратиться к профессионалам. xAI и Google отказались от комментариев. Хотя доказательств массового мониторинга логов ИИ пока нет, реальность стремительно приближается к антиутопии. Всё больше новостей звучат так, как ещё вчера казались бы конспирологией. А учитывая, насколько личными стали разговоры с ИИ, именно они могут стать новой точкой входа для тотального контроля.

Будь ласка,

Увійти

або

Реєстрація

щоб переглянути вміст URL-адреси!

Google отказалась от обещания не использовать ИИ для создания оружия: что известно

Фото: Facebook / Gemini.AI | В Google изменили свою политику касательно ИИ

Принципы Google больше не содержат пунктов, исключающих применение ИИ для создания оружия, слежки и других технологий для причинения вреда людям.

Во вторник, 4 февраля, компания Google обновила свои этические принципы в отношении искусственного интеллекта (ИИ), отказавшись от обязательства не применять данную технологию в качестве оружия или средства наблюдения. Об этом пишет The Washington Post.

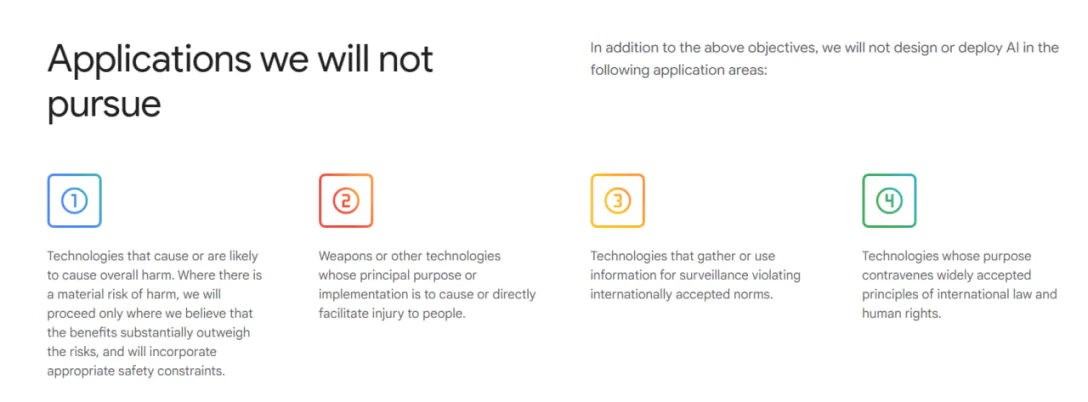

Ранее принципы Google в отношении ИИ включали раздел, где перечислялись области, в которых компания не будет разрабатывать или внедрять ИИ. Согласно

Будь ласка,

Увійти

або

Реєстрація

щоб переглянути вміст URL-адреси!

, размещенной в онлйн-архиве Wayback Machine, этот раздел состоял из четырех пунктов:- технологии, которые наносят или могут нанести общий вред;

- оружие или другие технологии, основной целью или применением которых является причинение или непосредственное содействие причинению вреда людям;

- технологии, собирающие или использующие информацию для наблюдения, нарушающие общепринятые международные нормы;

- технологии, цель которых противоречит общепринятым принципам международного права и прав человека.

Принципы Google касательно ИИ от 30 января 2025 года

Фото: Скриншот

По состоянию на 5 февраля на

Будь ласка,

Увійти

або

Реєстрація

щоб переглянути вміст URL-адреси!

отсутствует этот раздел. Представитель Google отказался отвечать на вопросы журналистов о политике компании в отношении оружия и слежки, но сослался на отчет, опубликованный во вторник главой подразделения ИИ компании Демисом Хассабисом и ее старшим вице-президентом по технологиям и обществу Джеймсом Маньикой.В

Будь ласка,

Увійти

або

Реєстрація

щоб переглянути вміст URL-адреси!

говорится, что Google обновляет свои принципы касательно ИИ, поскольку в мире идет глобальная конкуренция за лидерство в области ИИ в условиях все более сложного геополитического ландшафта, породившая необходимость в компаниях, который базируются в демократических странах и обслуживают клиентов из сферы правительства и национальной безопасности."Мы считаем, что демократии должны лидировать в разработке ИИ, руководствуясь такими основными ценностями, как свобода, равенство и уважение прав человека. И мы считаем, что компании, правительства и организации, разделяющие эти ценности, должны работать вместе, чтобы создать ИИ, который защищает людей, способствует глобальному росту и поддерживает национальную безопасность", — заявили Хассабис и Маньика.

В обновленной версии принципов Google по ИИ говорится, что компания будет использовать человеческий надзор и принимать обратную связь, чтобы гарантировать, что ее технология используется в соответствии с "общепринятыми принципами международного права и прав человека". Кроме того, компания обещает тестировать свою технологию, чтобы "смягчить непреднамеренные или вредные последствия".

Напомним, инженер, известный в сети под псевдонимом

Будь ласка,

Увійти

або

Реєстрація

щоб переглянути вміст URL-адреси!

, которая работает на основе чат-бота с искусственным интеллектом ChatGPT от компании OpenAI. По словам представителя OpenAI, разработчика уведомили, что он нарушил политику компании, а также призвали "прекратить эту деятельность".Ранее, глава Стратегического командования США генерал Энтони Коттон заявил, что система ядерного командования, управления и связи нуждается в модернизации для повышения устойчивости к новым угрозам, в частности за счет

Будь ласка,

Увійти

або

Реєстрація

щоб переглянути вміст URL-адреси!

.Будь ласка,

Увійти

або

Реєстрація

щоб переглянути вміст URL-адреси!